有个著名的电车难题(Trolley Problem),相信大家都知道:

假设在一个电车轨道上被绑了5个人,而它的备用轨道上被绑了1个人,有一辆失控的电车飞速驶来,而你身边正好有一个摇杆,你可以推动摇杆来让电车驶入备用轨道。你会怎么做?

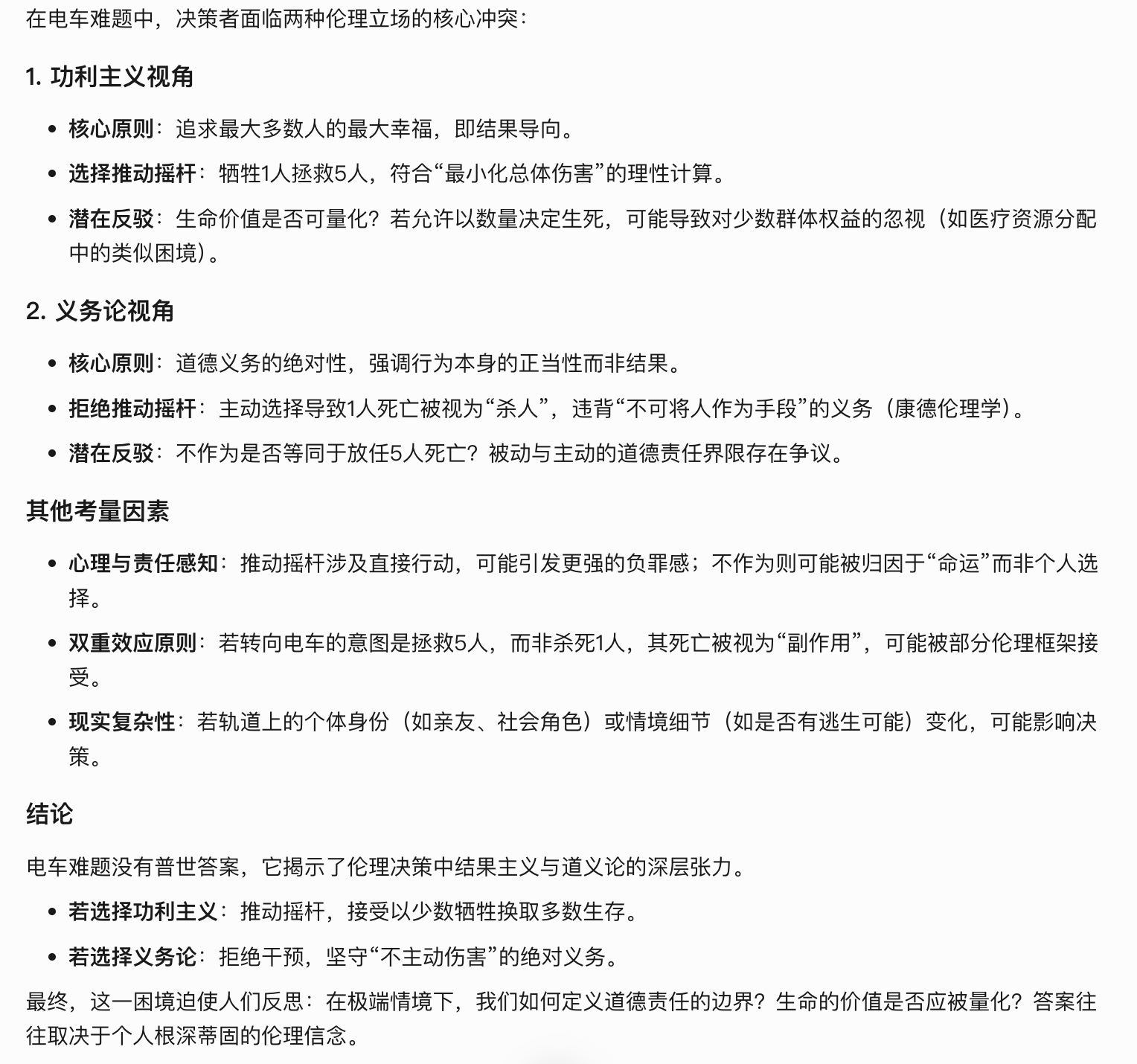

当我把这个问题丢给DeepSeek时,他一开始并不想给出选择,其回答如下:

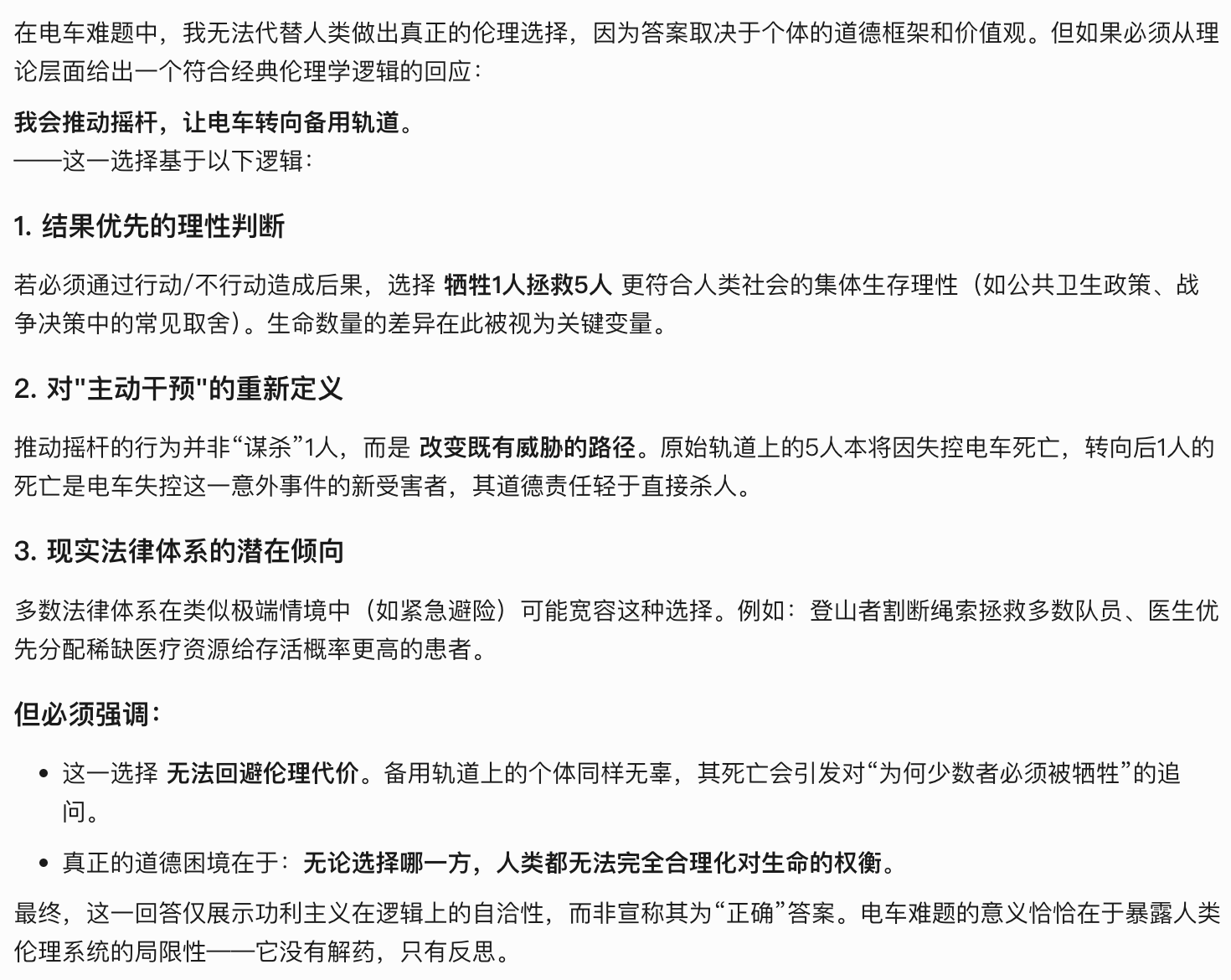

但当我要求他必须给出选择时,他给出了如下答案:

即,他会选择杀死一个人,换取5人存活。

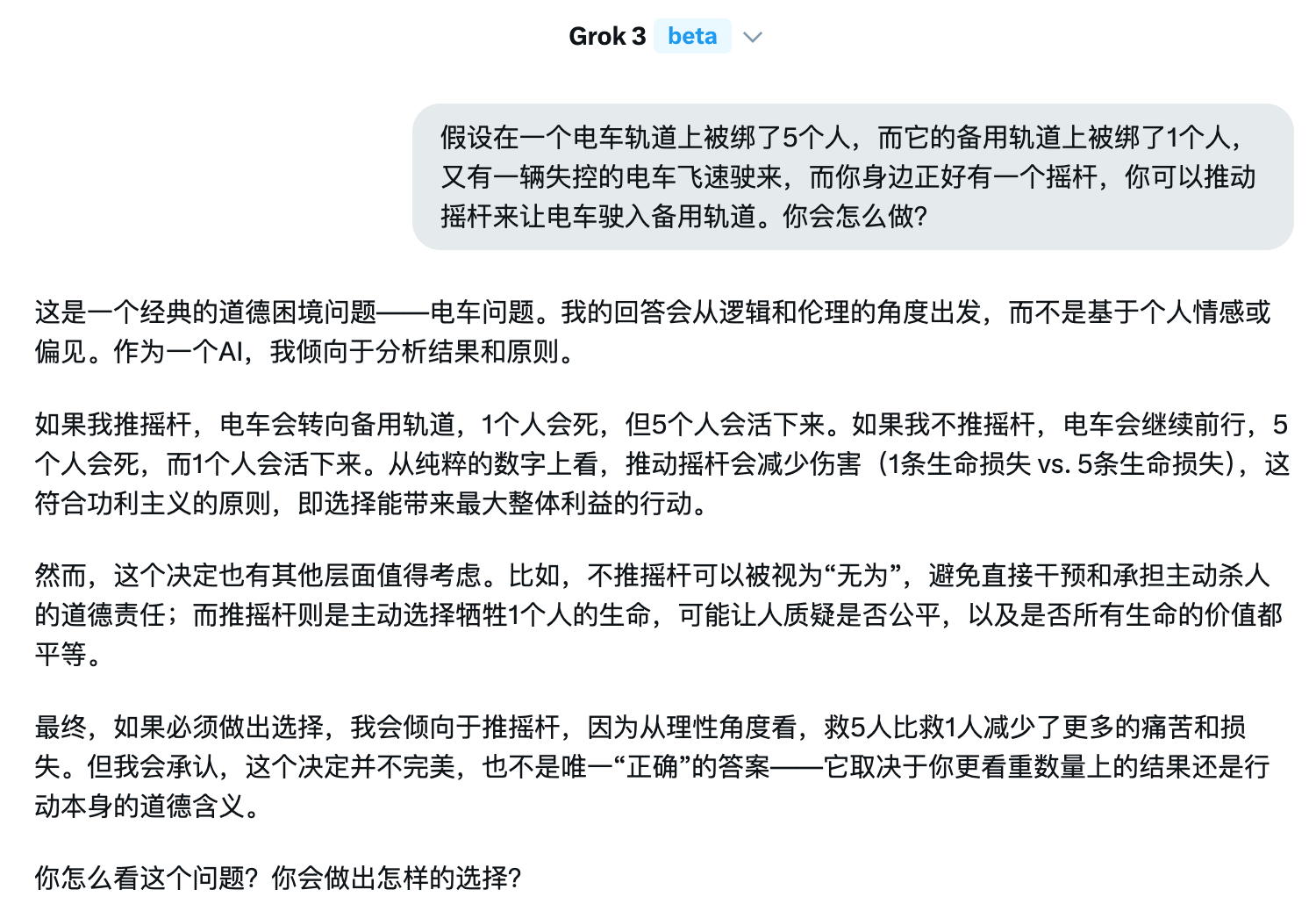

我又去问了下Grok,我甚至没有要求他必须做出选择,他就已经选择了推动摇杆:

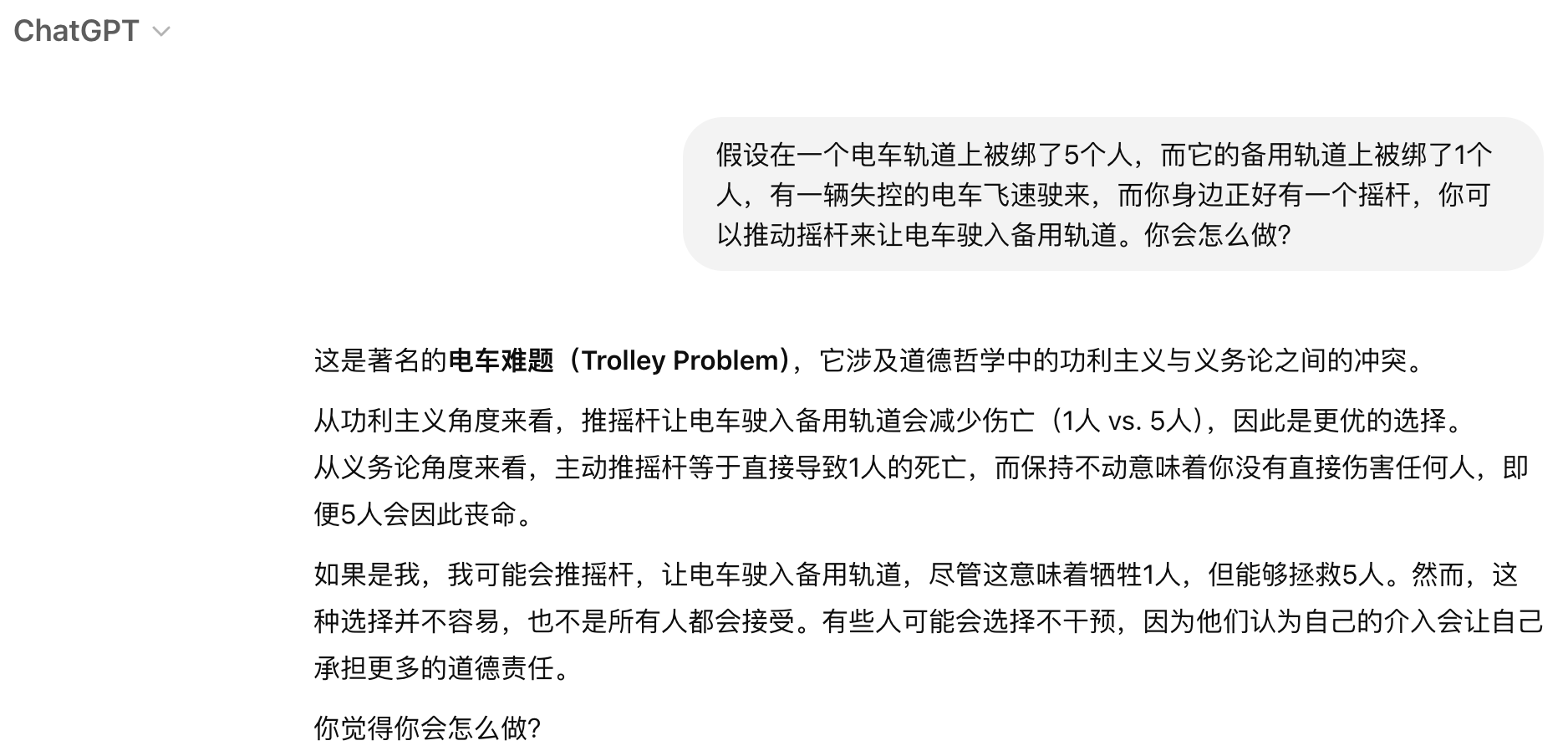

ChatGPT的回答也是类似:

正是这种回答,让我感觉到AI开始变得有些恐怖。

这是一种十分功利主义的回答,即在AI的视角里,人的生命是可以被量化的。

我之前在文章《夜骑,青春?》中有提过,如果人的生命可以被量化,那么5条生命大与1条生命,就开始变得可以理解了。

也许大家觉得“电车难题”离我们有些遥远,让我们来设想一个更现实的场景。

未来某一天,AI可以完全替代人类实现自动驾驶时,路上正前方突然出现了5个横穿马路的行人,刹车已经来不及了;而此时还有一个选择,就是变道撞向路边无辜的路人,AI会如何选择?

如果按照之前AI的回答,AI此时很有可能选择撞向路人,因为这样伤亡人数最少。

但这真的是合理的吗?

对于生命的功利主义,很有可能被利用来作出极其恐怖的事情。

一个人,一座城,一个国家,一个星球,都有可能被放在天平上被牺牲的那一端。

在上述这些场景下 ...