一.美化你的bash

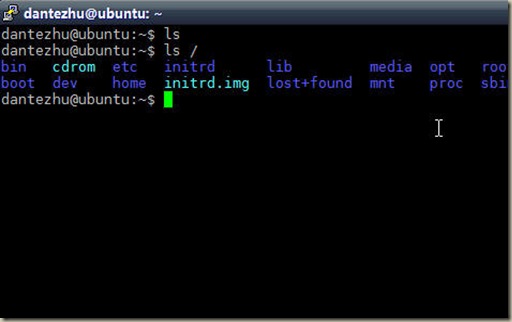

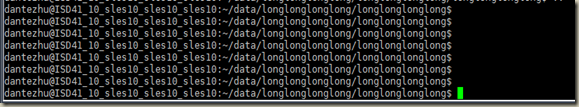

每次在进入一个很长的目录的时候,光标都会变得很靠右,很丑陋:

今天同事给了一段配置:

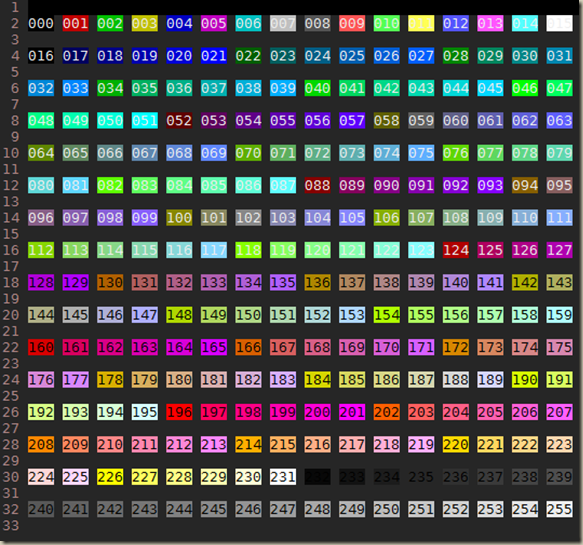

export PS1="\[\e[36;1m\]\u\[\e[0m\]@\[\e[33;1m\]\h\[\e[0m\]:\[\e[31;1m\]\w\[\e[0m\]\n\$ "

写入.profile后,会变成如下的样子,效果不错,哈哈:

二.在python中使用soap -- suds

今天需要通过soap来给RTX的其他用户发消息,于是研究了一下python中的soap包。

先是发现了SOAPpy,包括Dive into Python都推荐了这个包,不过经过我的试用之后,发现打死都显示不了任何数据,于是我搜啊。。终于在某个不起眼的角落看到了这样一段话:

Unfortunately, at the moment, I don't think there is ...